記者高兆麟/拉斯維加斯報導

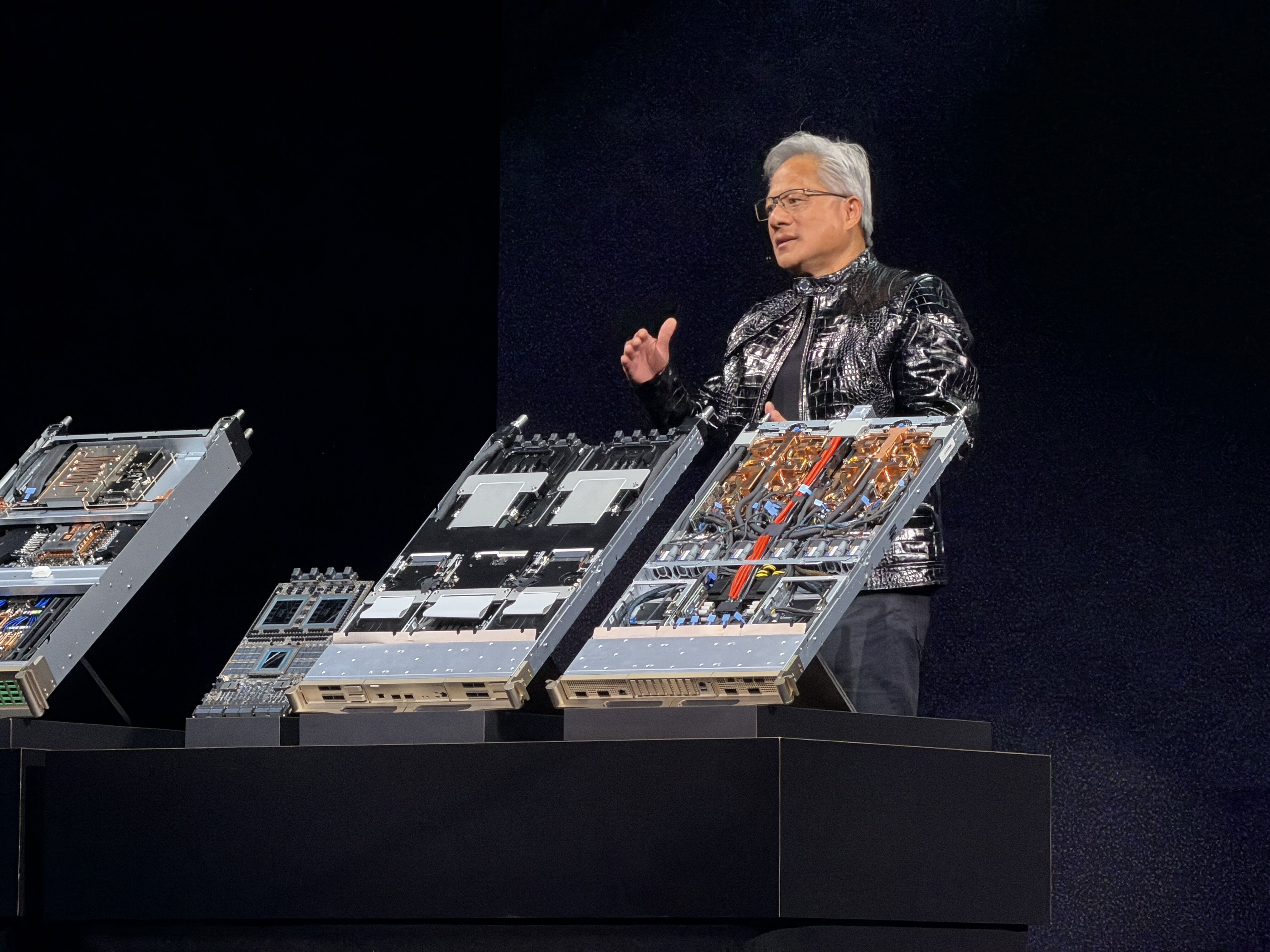

NVIDIA創辦人暨執行長黃仁勳今日在一年一度CES展前進行主題演講,大秀全新Rubin平台,更透露已經全面投產,其中還採用了晶圓代工龍頭台積電(2330)最新的COUPE技術,黃仁勳更表示,新的搭載Rubin的超級電腦平台採用全水冷設計,而且「沒有線路」,因此過去需要耗時兩個小時組裝的系統,現在只要五分鐘就可以完成組裝。

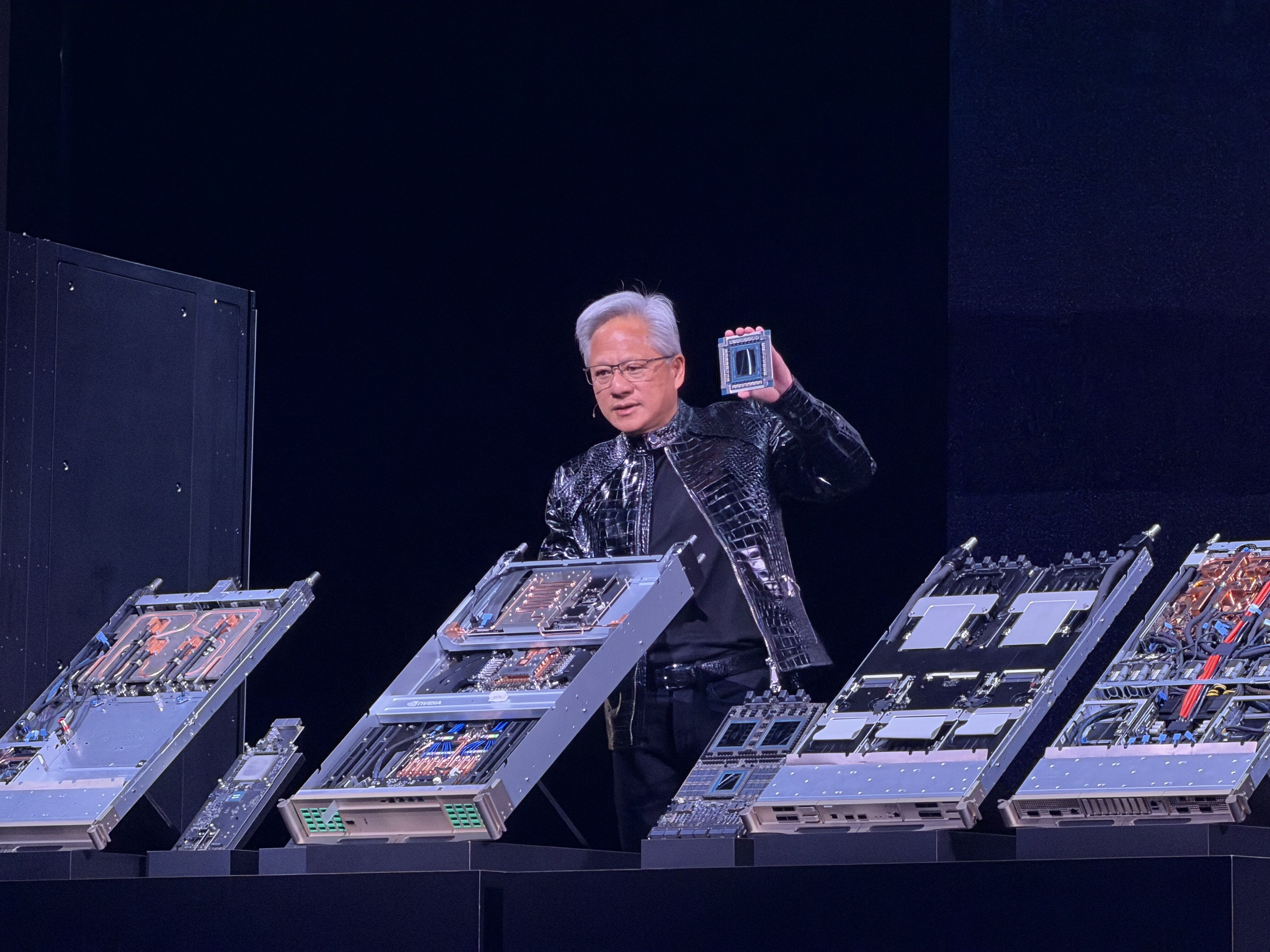

▲黃仁勳CES秀Rubin家族六大晶片。(圖/記者高兆麟攝)

黃仁勳此次在主題演講中,特別解釋為何新晶片被稱作Rubin,黃仁勳解釋,新晶片是以美國天文學家Vera Rubin命名,因為她的發現改變了人類對於宇宙的理解,以此命名也是因為這款晶片是為了解決產業目前面臨的根本性問題。

黃仁勳今日也介紹Rubin系列的六顆晶片,包括NVIDIA Vera CPU、NVIDIA Rubin GPU、NVIDIA NVLink 6 交換器、NVIDIA ConnectX-9 SuperNIC、NVIDIA BlueField-4 DPU以及NVIDIA Spectrum-6 以太網路交換器。

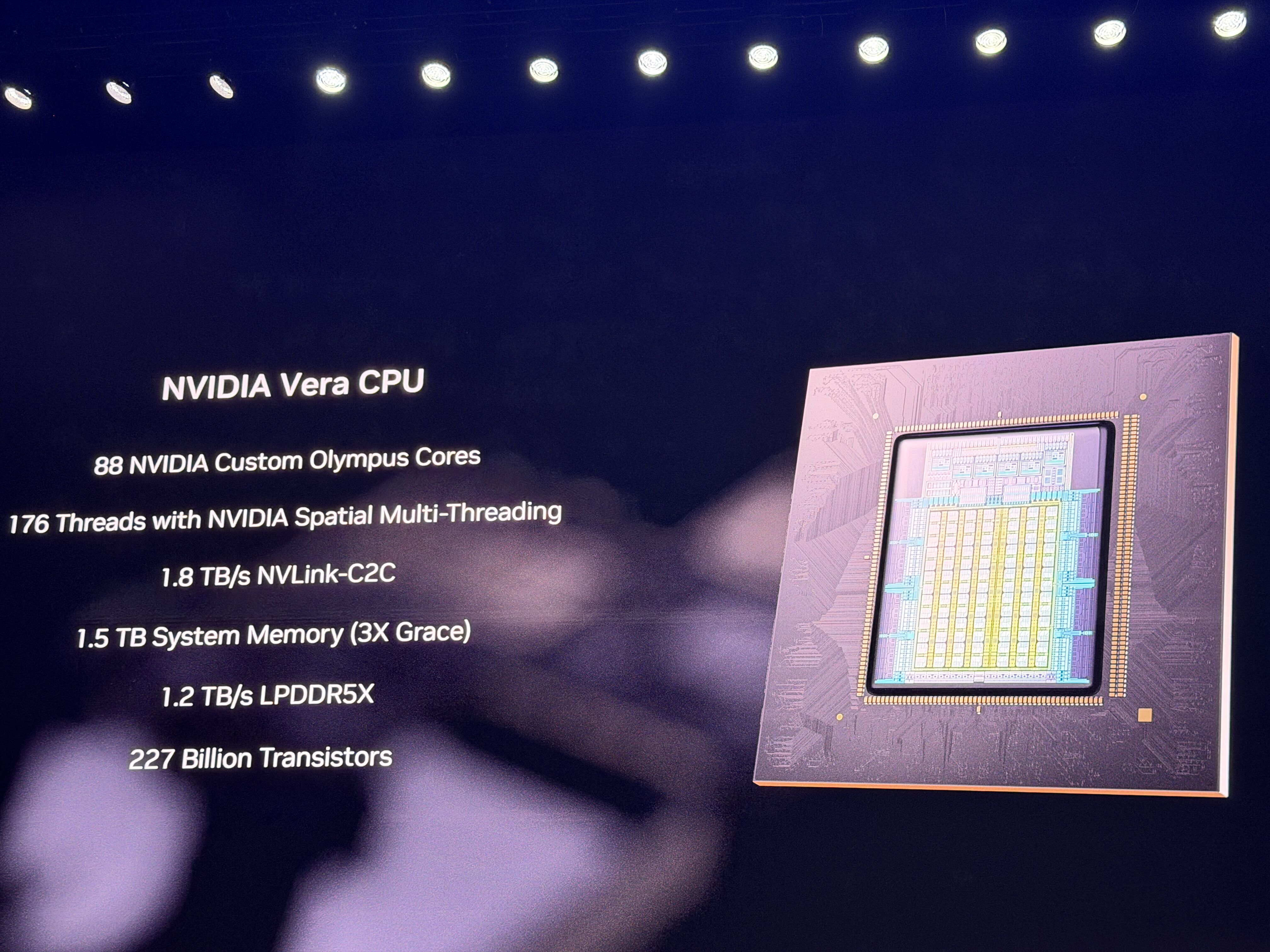

▲Vera CPU 。(圖/記者高兆麟攝)

黃仁勳表示,在硬體層面,Rubin GPU 搭載第三代 Transformer Engine,並導入硬體加速的自適應壓縮技術,推理效能達 50 petaflops(NVFP4)。Vera CPU 則以 88 顆自研 Olympus 核心打造,支援 Armv9.2 架構,並透過 NVLink-C2C 與 GPU 高速互連,主打高能效與推理導向運算。

互連技術方面,第六代 NVLink 提供單顆 GPU 3.6TB/s 的頻寬,NVL72 機櫃總頻寬高達 260TB/s,輝達形容其頻寬規模已超越整個網際網路。NVLink 6 同時加入網內運算(in-network compute)與強化維修設計,以因應超大型 AI 訓練與推論需求。

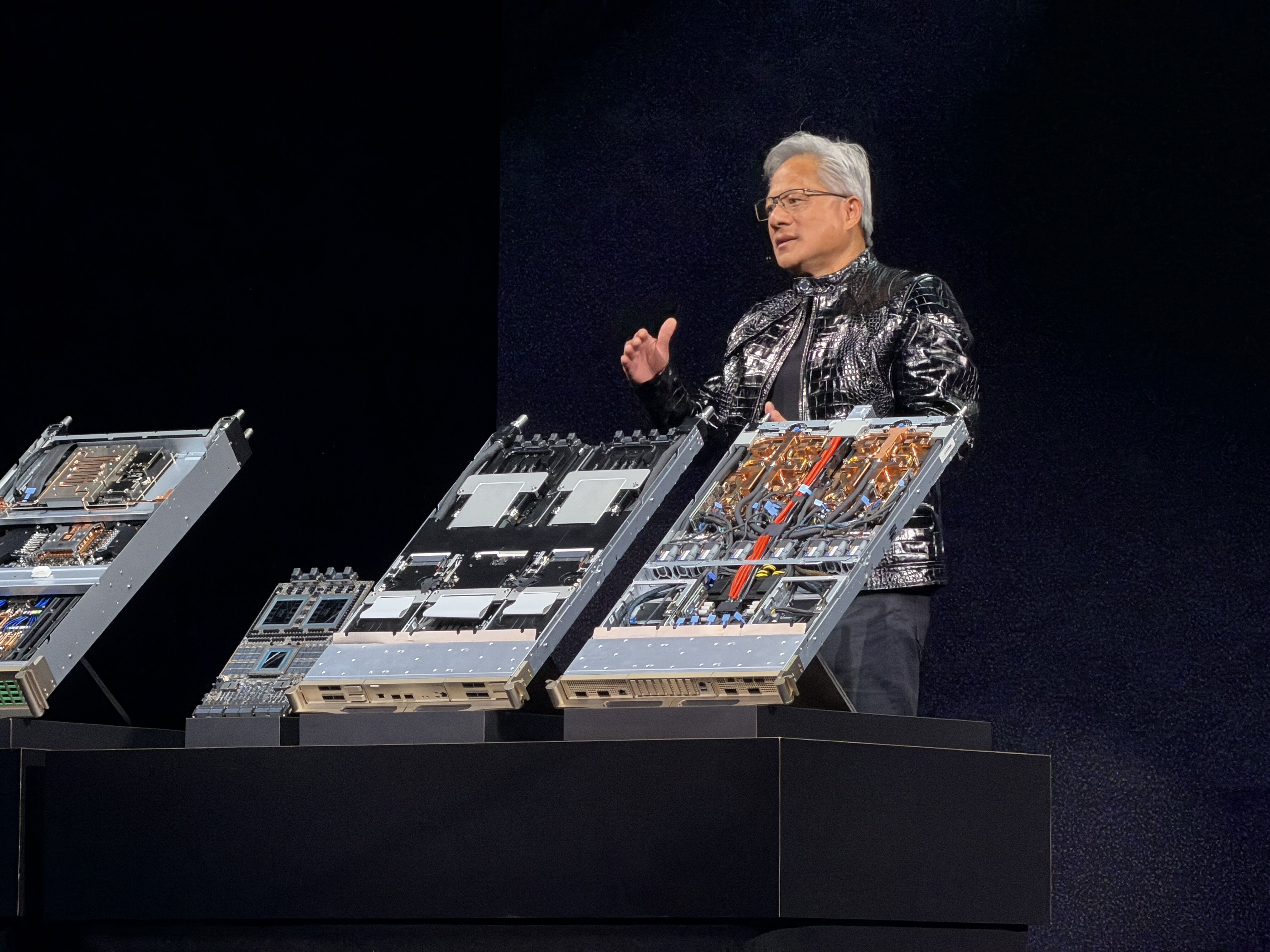

▲黃仁勳CES介紹Rubin晶片。(圖/記者高兆麟攝)

在系統層級,Rubin 成為首個在機櫃尺度全面支援機密運算的平台,確保 CPU、GPU 與 NVLink 間資料全程受保護,鎖定大型專有模型與多租戶 AI 工廠應用。第二代 RAS 引擎則透過即時健康監測與模組化設計,提升整體系統穩定性,維修與組裝效率也較前代大幅提升。

輝達也同步推出 AI 原生儲存概念「Inference Context Memory Storage Platform」,結合 BlueField-4 DPU,讓推論過程中的 key-value cache 能在系統間共享與重用,支援長上下文、多輪推理與代理式 AI 應用,並提升整體能效。

▲黃仁勳CES介紹Rubin晶片。(圖/記者高兆麟攝)

網路方面,Rubin 平台搭配新一代 Spectrum-6 乙太網與 Spectrum-X 光學交換技術,主打更高可靠度與更佳功耗表現,並可讓跨數百公里的資料中心協同運作,形同單一 AI 工廠。

讀者迴響